지난 시간 정리

우리는 MSE(Mean Squared Error)를 사용하여 빨간 선을 찾는 것이 합리적인지 알아보기 위해 MLE(Maximum Likelihood Estimation)를 공부하고 있습니다. 지난 시간에는 MLE를 더 잘 이해하기 위해 이항분포와 함께 순열(Permutation)과 조합(Combination)을 공부했습니다.

다시 제주도 옆 우도 예제를 보면서 MLE로 가봅시다.

$$ L(\theta) = P(D ; \theta) = \binom {10}{7}\theta^7(1-\theta)^3 $$

이항분포와 조합을 이해한 후 이 식이 더 잘 보일 것입니다. 마지막 식이 아직 어색하다면 이전 강의를 참고해 주세요. 이제, 개를 7번 고양이를 3번 봤을 때 정말 개를 볼 확률이 $\frac {7}{10}$이였을 때 최대우도가 되는지 보겠습니다. 다시 말해, $\theta = \frac {7}{10}$ 일 때 개를 7번 고양이를 3번 본 사건이 가장 "있음 직한 일"인지 확인하겠습니다.

강의 보러 가기: https://youtu.be/sjLQctg61iY?si=Iujle4rvpXWlKSxY

Likelihood의 가정 IID (Identically Independently Distributed)

우도의 가정을 분석해 봅시다.

$$ L(\theta) = P(D ; \theta), D \, are \, IID $$

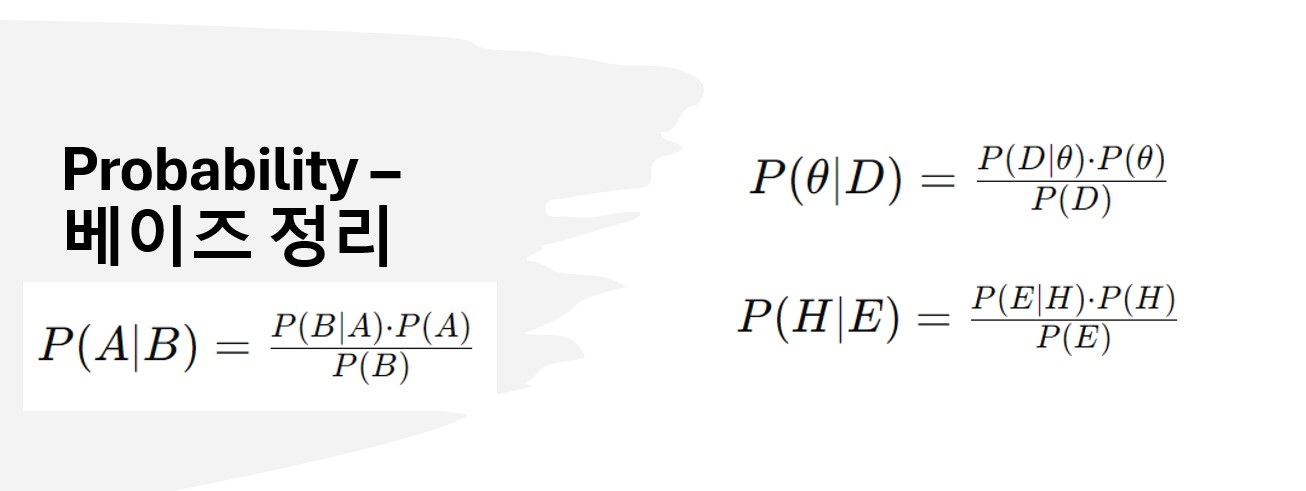

$L(\theta)$는 $\theta$에 대한 Likelihood 함수라는 의미입니다. $P(D ; \theta)$는 $\theta$를 파라미터로 하는 데이터의 확률을 의미합니다. 베이즈 정리의 Likelihood와 약간 차이가 있습니다. 베이즈 정리에서 우도는 $P(D | \theta)$ 였습니다. $\theta$는 사전믿음(사전 확률, Prior)이었고 이를 기반으로 Data의 확률이 어떻게 되느냐의 관점이었습니다.

Data가 IID 하다는 가정을 해야 합니다. 엄청 어렵게 다가오실 수도 있지만 사실 별거 아닙니다. 우도를 돌면서 개를 볼 때 첫 번째 개를 봤어도 두 번째로 개를 볼 확률이 변하지 않는다는 겁니다.

(사실은 변할 수도 있는 거죠? 개를 이미 봤으니까 두 번째로 볼 때는 처음 본 개를 제외하고 계산할 수 있는 가정을 할 수 있는 거니까요)

이렇게 가정해야 이항분포 식이 나옵니다. 이항분포를 배울 때 각 사건이 독립적이다라는 가정을 했던 거 기억하시는 분들도 있을 겁니다. 동전 던지기로 생각해 보면, 바로 직전에 동전이 앞면이 나왔다고 다음에 앞면이 나올 확률이 변하는 게 아니라는 뜻입니다.

Likelihood 수식

최종적으로 식은 다음과 같이 표현됩니다

$$ L(\theta) = P(D ; \theta) = \binom {10}{7}\theta^7(1-\theta)^3 $$

그럼 $L(\theta)$를 최대로 하는 $\theta$는 어떻게 구할까요? 최댓값, 최솟값을 구하려면 미분이라는 좋은 방법이 있습니다. 그런데 위 식을 보니까, 미분이 너무 복잡해 보입니다. $\theta^{10}$ 항이 나오는 게 미분하기 싫어지는 기분이 확 듭니다.(미분이 불가능하다는 뜻이 아닙니다.)

우리는 이럴 때 Log를 사용할 수 있습니다.

Log의 도입

왜 로그를 도입해도 될까요? 위 강의 9분 44초부터 자세히 설명했으니 원리가 궁금하신 분들은 강의를 보시는 게 좋습니다.

간단히 말하면, 로그를 취해도 $0\le\theta\le1$에서 log를 취하기 전 $L(\theta)$와 비슷한 형태를 유지하기 때문입니다. 즉, 같은 $\theta$에서 최댓값을 갖는다는 겁니다. 또한, 로그를 사용하면 곱셈을 덧셈으로 바꿀 수 있습니다. 로그를 취한 우도를 log Likelihood라고 하고, 이를 $l(\theta)$로 정의합니다.

$$ l(\theta) = \log L(\theta) = \log \theta^7 (1-\theta)^3 $$

위와 같이 됩니다. 위 식을 보니까 훨씬 미분하기 수월하다는 게 느껴집니다.

결론

위 식을 미분해서 $theta$값을 구하면 $\frac {7}{10}$이 나옵니다. 이로써, 우리의 직관대로 개를 볼 확률이 $\frac {7}{10}$일 때 우리의 Likelihood 함수가 최댓값을 갖는 것을 확인할 수 있었습니다.

세부풀이와 원리가 궁금하신 분은 강의를 시청해 주세요 ^^. 강의 안 봐도 되는 분들을 위해서 우리 예제의 Likelihood와 Log Likelyhood 함수의 그래프를 첨부합니다.

'Machine Learning' 카테고리의 다른 글

| 20강 [확률과 통계 1부] 확률변수/확률함수/확률분포 (0) | 2024.11.24 |

|---|---|

| 19강 [MLE 5부] 가우시안 분포(정규분포) 데이터의 MLE (0) | 2024.09.01 |

| 17강 [최대우도추정법, MLE 3부] 로또확률 및 이항분포 (0) | 2024.08.31 |

| 16강 [최대우도추정법, MLE 2부] Bayes 정리에 있는 우도와 MLE 소개 (0) | 2024.08.24 |

| 15강 [최대우도추정법 MLE 1부] 확률에 대한 철학적 접근(MSE는 합리적인가?) (0) | 2024.08.21 |