안녕하세요?

선형회귀를 공부하고 있는 이유

우리는 지금 선형회귀를 공부하고 있습니다. 그런데 왜 선형회귀를 공부해야 할까요?

공부하면서 중간중간에 "내가 왜 이걸 공부하고 있지?"라는 질문을 스스로에게 던지는 것이 중요합니다. 이는 공부에 대한 동기 부여와 내용을 깊이 이해하는 데 도움이 됩니다. 제가 자주 사용하는 공부 방법이기도 합니다.

Syllabus가 있는 강의나 책으로 공부할 경우, 반드시 처음에 목차와 세부 목차를 보면서 전체 내용을 예측하고 세부 내용을 공부하는 것이 좋습니다. 세부 내용을 공부할 때는 앞뒤 연결 관계와 이 내용이 전체에서 어떤 위치에 있는지를 이해하는 것이 중요합니다. 그리고 한 단원이 끝날 때마다 그 내용을 머릿속으로 정리해 보세요.

시험 전날 벼락치기를 할 때도 이런 식으로 공부하는 것이 유익하며, 시간이 허락한다면 각 단원의 내용을 노트로 정리하는 것도 좋은 방법입니다. 중요한 것은 노트를 잘 필기하는 것이 아니라, 머릿속에서 내용이 잘 정리되도록 하는 것입니다. 단원이 끝난 후에 노트를 보지 않고 내용을 재구성해보는 것이 중요합니다. 가능하다면, 여러분도 직접 강의를 만들어보세요. 자신이 이해한 내용을 다른 사람에게 설명할 수 있을 때, 진정으로 그 내용을 이해한 것입니다.

기술사 시험이나 대학원 입시와 같이 방대한 양을 준비할 때는 반복 학습이 중요합니다. 반복 학습을 통해 점차 노트의 내용을 줄여가면서, 제목만 봐도 내용이 머릿속에서 자연스럽게 떠오를 수 있도록 훈련하는 것이 이상적입니다.

선형회귀와 머신러닝

선형회귀는 머신러닝에서 예측에 사용하는 가장 기본적인 알고리즘 중 하나입니다. 우리는 면적, 방의 수 등의 특성이 집값에 선형적으로 영향을 미치는 예를 통해 이 알고리즘을 학습했습니다. 이 과정에서 우리의 데이터에 대해 빨간 선을 그렸고(즉, 모델을 수립했고), 이 모델을 통해 새로운 데이터를 예측할 수 있었습니다.

이 빨간선을 그리기 위해 사용한 것은 평균 제곱 오차(MSE, Mean Squared Error)입니다.

MSE는 다음과 같이 정의됩니다:

$$ L(w) = \frac {1}{N}\sum_{i=1}^N (w^Tx_{i} - y_{i})^{2} $$

이때 우리가 고민해 볼 수 있는 질문은, "과연 MSE를 최소화하는 방식으로 빨간 선을 그리는 것이 합리적인가?" 하는 것입니다. 만약 다른 방법으로도 MSE를 통해 우리의 빨간선을 찾는 것이 옳다는 것을 확인할 수 있다면, 우리는 더욱 확신을 가지고 이 방법을 사용할 수 있을 것입니다.

따라서 이번 시간에는 확률적 가정을 통해 MSE로부터 빨간선을 찾는 것이 맞다는 것을 증명하고자 합니다. 이를 위해 먼저 확률 이론을 공부하겠습니다.

제가 설명하는 부분은 제가 이해한 내용이므로, 완벽하지 않을 수 있습니다. 하지만 제 설명이 여러분의 이해에 도움이 되기를 바랍니다. 또한, 여러분이 더 잘 알고 있는 내용이 있다면 저에게도 가르쳐주세요.

강의보고오기: https://www.youtube.com/watch?v=pzf4nqN_yCI

확률 이론의 철학적 배경: 존재론 vs 인식론

갑자기 존재론과 인식론이 나옵니다. 저도 처음에 MA Book을 보는데 당황스러웠습니다.

위 표에서 보면 확률이론을 두 가지 관점에서 보고 있습니다. 존재론적 커밋먼트와 인식론적 커밋먼트. 그래서 우리는 먼저 존재론과 인식론에 대해서 이해할 필요가 있습니다.

존재론(Ontology): 존재론은 우리가 무언가가 실제로 존재하는지에 대한 질문을 던집니다. 확률 이론에서 존재론적 관점은 특정 사건이 객관적으로 존재하고, 그 사건의 사실 여부에 관심을 둡니다.

인식론(Epistemology): 인식론은 우리가 무엇을 어떻게 아는지에 대한 질문을 다룹니다. 확률 이론에서 인식론적 관점은 어떤 사실에 대한 믿음의 정도를 다루며, 이 믿음을 0과 1 사이의 숫자(0, 1 포함)로 표현합니다.

사실 철학적 내용은 저도 정말 잘 모르는 내용이니 아래 유튜브를 참고해 주시기 바랍니다.

Ontology/Epistemology: https://study.com/academy/lesson/ontology-vs-epistemology-differences-examples.html

(유료입니다. 여유되시는 분들은 결제해서 보세요)

영문 유튜브:

https://www.youtube.com/watch?v=F2mHeudPGNI

https://www.youtube.com/watch?v=hkcqGU7l_zU

한글 유튜브:

https://www.youtube.com/watch?v=YmO_6Fskt_w

https://www.youtube.com/watch?v=qxHvg6y9sZM

확률의 이해

확률 이론은 존재론적 관점에서는 사실에 초점을 맞추고, 인식론적 관점에서는 그 사실에 대한 믿음의 정도를 0과 1 사이의 숫자로 표현합니다. 예를 들어, 어떤 사건이 일어날 가능성을 70%로 표현한다면, 이는 그 사건에 대한 믿음의 정도를 나타내는 것입니다..

퍼지 논리는 존재론적 관점에서 사실을 받아들일 때 0과 1 사이의 값으로 표현합니다. 그러나 퍼지 논리는 더 유연하게 사실을 다룹니다. 더 자세한 내용은 아래의 유튜브 링크를 참고해 주시기 바랍니다.

Fuzzy의 이해: https://www.youtube.com/watch?v=CBTEVFphv-E

Fuzzy vs Probability: https://www.youtube.com/watch?v=RXThpkgba7w&list=PLO-6jspot8AL5wrkCNUXAJ8_0qHli6Zat&index=1

제 강의에서는 명제논리, 술어논리 등에서도 간략하게 설명합니다. 그리고 확률과 Fuzzy의 차이점을 설명하기 위해, 켄타우로스의 예를 들었습니다.

각 Language에서 차이점을 보면, 아래와 같이 표현할 수 있습니다.

확률: 켄타우로스는 사람이야. 사람일 확률은 60%야

Fuzzy: 켄타우로스는 60% 사람이고, 40%는 말이야. 켄타우로스는 사람에 가까워.

빈도주의(Frequentist) vs 베이지안(Bayesian)

이제 확률에 대한 두 가지 관점을 보겠습니다. 빈도주의와 베이지안입니다.

빈도주의(Frequentist):

빈도주의자는 확률을 객관적인 사실로 봅니다. 예를 들어, 동전의 앞면이 나올 확률을 계산할 때, 수많은 동전 던지기 실험을 통해 이 확률을 계산합니다. 즉, 실험 결과에 기반한 객관적 확률을 중요시합니다. 한 번 동전을 던진 결과에 대해서는 확률을 말할 수 없다고 보는 것이 빈도주의자의 입장입니다.

(빈도주의자는 존재론적 관점과 많이 닮아있습니다. 빈도주의자는 사실 자체에 관심이 있습니다. 빈도주의는 동전의 확률을 말할 때 수없이 많은 횟수를 던졌을 때 나온 결과에 따라 확률을 말합니다. 주관적 믿음이 아니라 사실 자체로 받아들인다고 할 수 있습니다. 강의에서 예시처럼 동전을 던진 다음에 확률을 말하라고 하면, 이미 던진 결과에 대한 확률은 없다고 합니다.)

베이지안(Bayesian):

베이지안 관점에서는 확률을 주관적인 믿음으로 봅니다. 동전을 던지기 전에도, 던진 후에도 확률을 말할 수 있습니다. 또한, 새로운 증거를 얻을 때마다 기존의 믿음(사전 확률)을 업데이트하여 확률을 재계산합니다.

(베이지안은 인식론적 관점처럼 확률을 믿음으로 봅니다. 따라서 동전을 던지기 전과 던진 후에도 확률을 말할 수 있습니다. 그리고 결과를 본 후에 사전믿음을 업데이트합니다.)

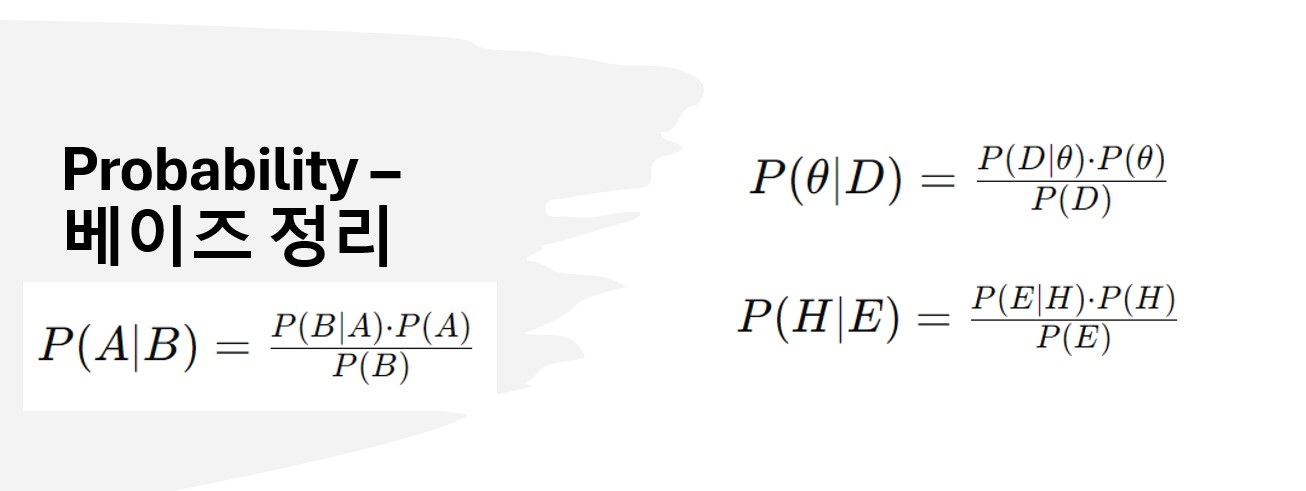

베이즈 정리

베이지안관점

베이즈 정리는 베이지안 확률론에서 중요한 역할을 하는 수학적 정리로, 관측된 데이터를 바탕으로 초기 가정이나 믿음을 업데이트하는 방법을 설명합니다. 이 정리는 새로운 증거나 데이터를 반영하여 사전 확률(사전 믿음)을 사후 확률(사후 믿음)로 갱신하는 과정에서 사용됩니다.

베이즈 정리 수식의 의미

그림 왼쪽의 식 $P(A|B) = \frac {P(B|A) P(A)}{P(B)}$는 조건부 확률의 기본 성질을 나타내며, 사건 $A$가 주어졌을 때 사건 $B$가 발생할 확률을 계산합니다. 하지만 이것만으로는 베이지안 관점에서의 베이즈 정리를 완전히 설명하지는 않습니다.

베이즈 정리와 베이지안 접근

베이즈 정리가 진정으로 의미를 갖기 위해서는 베이지안 관점이 필요합니다. 베이지안 접근법에서는 우리의 사전 믿음 $\theta$를 설정한 후, 데이터를 관찰하고 이를 바탕으로 우리의 믿음을 업데이트합니다.

오른 쪽 아래식으로 설명하면, 어떤 가설 $H$를 세우고 증거 $E$를 관찰한 후, 우리는 베이즈 정리를 통해 이 가설이 맞을 확률을 갱신할 수 있습니다. 위 그림에서 오른쪽의 식이죠.

여기서:

$P(H|E)$: 증거 $E$가 주어졌을 때 가설 $H$가 참일 확률 (사후 확률)

$P(E|H)$: 가설 $H$가 참일 때 증거 $E$가 나타날 확률

$P(H)$: 가설 $H$가 참일 사전 확률 (사전 믿음)

$P(E)$: 증거 $E$가 나타날 전체 확률

이렇게 베이즈 정리는 기존의 믿음($P(H)$)을 새로운 증거($E$)에 따라 어떻게 업데이트해야 하는지를 수학적으로 설명합니다.

최대우도추정법(MLE, Maximum Likelihood Estimation)

위의 모든 내용은 앞으로 설명할 MLE를 좀 더 확실히 이해하기 위한 내용들입니다. MLE를 왜 하냐고요? MSE가 과연 합리적인지 알아보기 위해 확률적 가정으로도 MSE를 통해 빨간 선을 구하는 것이 맞나 본다고 했습니다. 다음 시간부터 MLE를 공부하도록 하겠습니다.

'Machine Learning' 카테고리의 다른 글

| 17강 [최대우도추정법, MLE 3부] 로또확률 및 이항분포 (0) | 2024.08.31 |

|---|---|

| 16강 [최대우도추정법, MLE 2부] Bayes 정리에 있는 우도와 MLE 소개 (0) | 2024.08.24 |

| 14강 서브노트 (Parameter, GD, Overfitting, Dropout) (0) | 2024.08.12 |

| 13강 그라디언트 디센트 알고리즘 및 종류(추가 오버피팅) (0) | 2024.08.12 |

| 12강 최적화와 그라디언트 디센트 (0) | 2024.07.30 |